[Pytorch] 쉽고 빠르게 배우는 NLP

자연어 처리의 기본 원리를 차근차근 살펴봅시다

- 딥러닝에 대한 기본 지식을 갖고 계신 분

- 파이썬 프로그래밍 언어에 익숙하신 분

인공지능의 세계를 탐험하고 계신 여러분이라면

'자연어 처리'에 대해 들어본 적이 있거나

관심을 가지고 계실 겁니다

자연어 처리의 동작 원리는 어렵다?

자연어 처리에 관심 있으신 분이라면

Transformer, BERT 모델에 대해 들어보셨을 겁니다

하지만 Transformer, BERT 모델의 동작 원리는

난해하게 느껴지지 않으셨나요?

그 이유는 간단합니다

기본이 부족하기 때문이죠

기본부터 채우는 커리큘럼

첫 번째, 자연어 처리의 기본

가장 기초적인 자연어 처리의 기본 지식을

먼저 학습하여 앞으로 배울 내용들을 위한

토대를 마련합니다

두 번째, Embedding

자연어를 표현할 때 범주형 변수로 표현했던

기존 방법론에 대한 한계점을 제시하고,

이를 극복할 수 있는 자연어 표현 방법론을 설명합니다

방법론에 대한 핵심 내용과 함께, 이를 실제로 어떻게

사용할 수 있는지 실습을 진행하며 설명합니다

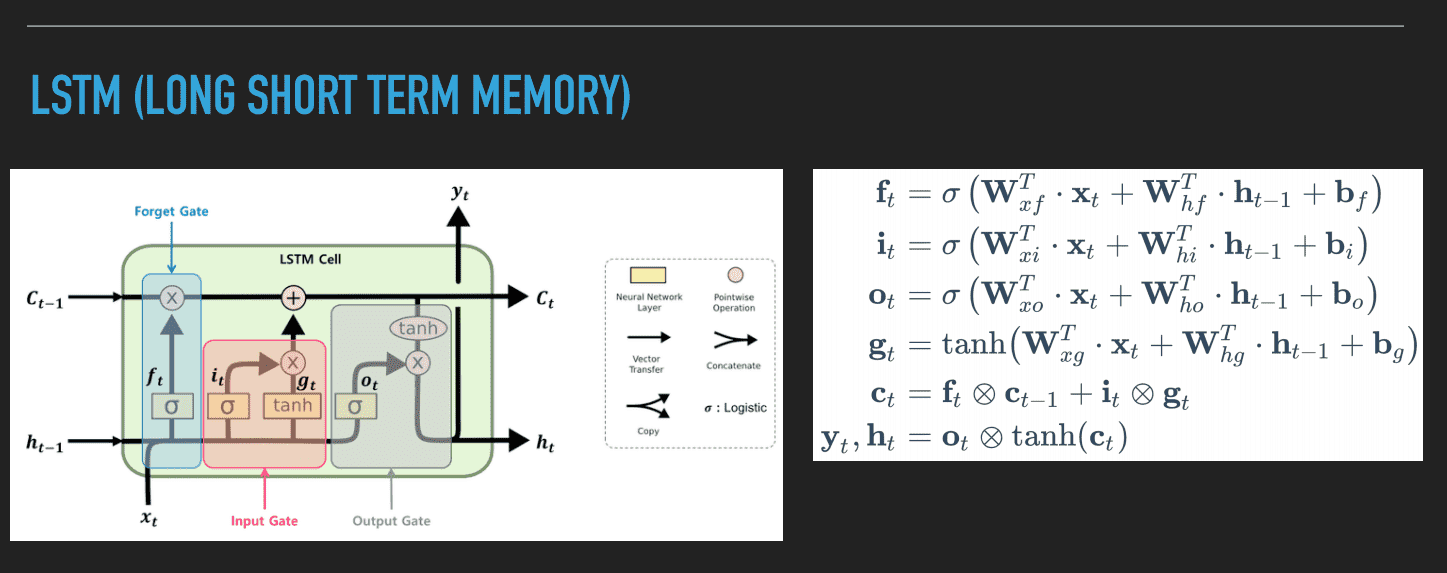

세 번째, Recurrent Neural Network

자연어의 특징을 잘 반영할 수 있는

Recurrent Neural Network(RNN: 순환 신경망)

딥러닝 모델에 대해 공부할 예정입니다

RNN 모델의 Feeding 과정을 수식적으로 배우며,

함께 발전한 Long Term Short Memory(LSTM),

Gated Recurrent Unit(GRU) 모델 역시

수식적으로 Feeding 과정을 설명합니다

네 번째, Task

자연어 처리 분야에서는 많은 Task가 존재합니다

가장 대표적인 Task인 Neural Machine Translation과

Tagging이 무엇인지 살펴봅시다

각 Task별 구체적인 예시와 더불어 분석 방법에 대한

대표적인 딥러닝 모델 구조를 제시하며,

데이터의 Weight Feeding 과정을 설명합니다

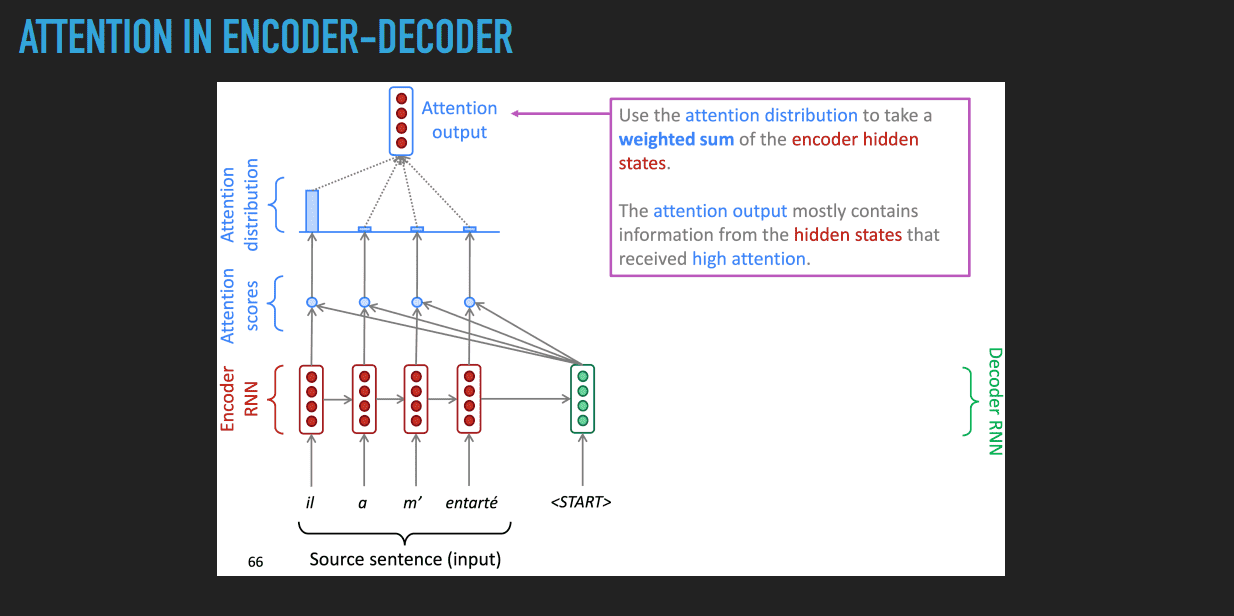

마지막, Attention

RNN 모델의 한계점을 제시하며 이를 개선하기 위한

방법론 중 자연어 처리 분야에서 최근 떠오르고 있는

메커니즘인 Attention 기법을 소개합니다

Attention Mechanism을 이용한

Neural Machine Translation과,

Attention Mechanism을 활용한

Tagging 각각에 대해 어떤 방식으로

적용할 수 있는지 설명하고자 합니다

NLP 트렌드까지 한 눈에

연구를 계속하고 있는 전공자의 시선으로

최근 자연어 처리 분야에서 중요하게 연구되고

있는 분야를 소개합니다

또한, 본 강좌를 수강한 후

자연어 처리에 대해 어떤 방식으로 공부하면

좋을지 그 방향성을 제안합니다

이런게 궁금하실 겁니다

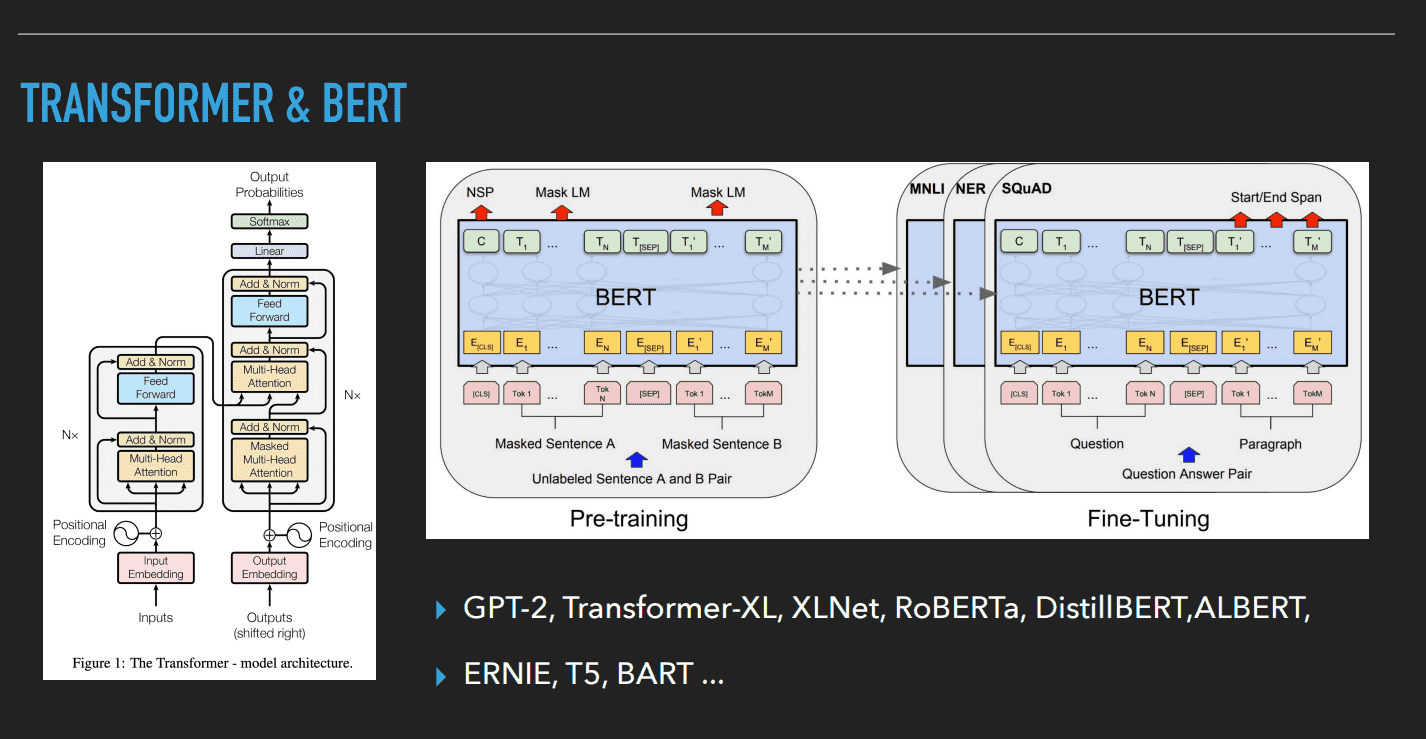

Transformer, BERT 모델을 설명하나요?

자연어 처리에 대한 기초를 다루고 있어,

해당 모델들에 대한 간략한 소개를 다룰 뿐

구체적인 내용은 다루지 않고자 합니다

다만 Transformer, BERT 모델에 대해

공부하시고자 할 때 필요한 기본지식을

꼼꼼히 갖출 수 있도록 도와드립니다

선수 지식이 필요한가요?

본 강좌는 [Pytorch] 쉽고 빠르게 배우는 딥러닝의

후속 강좌이며, 딥러닝 기본 또는 딥러닝 알고리즘

기본 지식을 갖고 있는 분들을 대상으로 합니다

실습은 어떻게 진행되나요?

이론 내용에 관련된 실습 코드를 준비했습니다

코드는 공유드리지만, 라인 바이 라인으로 코드를

작성하며 복습해보시는 것을 추천드립니다

🌟딥러닝 기초를 단단하게

Justin

연세대학교 산업공학과 석사과정

DataScience, Deep Learning 관련 연구 진행

쉽고 빠르게 배우는 딥러닝 강좌에서

실습 파트를 담당했습니다

제 Github에 놀러오세요!

all Icon made by Freepik from www.flaticon.com

- 01Section0. 자연어 처리 기초

- 02Section1. 자연어 처리 분야의 대표적인 태스크5개 (01:43:39)

- 03Section2. 자연어 처리에 대한 트렌드1개 (17:44)